Неуронска мрежа ширења унапред

Неуронска мрежа ширења унапред (енгл. feedforward neural network, FNN) је један од два широка типа вештачке неуронске мреже, коју карактерише правац тока информација између њених слојева.[2] Његов ток је једносмеран, што значи да информације у моделу теку само у једном правцу — напред — од улазних чворова, преко скривених чворова (ако их има) и до излазних чворова, без икаквих циклуса или петљи,[2] за разлику од рекурентних неуронских мрежа,[3] које имају двосмерни ток. Модерне мреже унапред су обучене коришћењем методе пропагације уназад[4][5][6][7][8] и колоквијално се називају „ванила” неуронске мреже.[9]

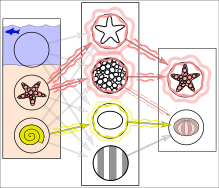

Поједностављени пример обуке неуронске мреже у откривању објеката: Мрежа је обучена помоћу више слика за које је познато да приказују морске звезде и морске јежеве, који су у корелацији са „чворовима“ који представљају визуелне карактеристике. Морске звезде се поклапају са прстенастом текстуром и звездастим обрисом, док већина морских јежева одговара пругастој текстури и овалном облику. Међутим, пример морског јежа са прстенастом текстуром ствара слабо пондерисану повезаност између њих.

Накнадно покретање мреже на улазној слици (лево):[1] Мрежа исправно детектује морску звезду. Међутим, слабо пондерисана повезаност између прстенасте текстуре и морског јежа такође даје слаб сигнал овом последњем из једног од два средња чвора. Поред тога, шкољка која није била укључена у обуку даје слаб сигнал за овални облик, што такође резултира слабим сигналом за излаз морског јежа. Ови слаби сигнали могу резултирати лажно позитивним резултатом за морског јежа.

У стварности, текстуре и обриси не би били представљени појединачним чворовима, већ повезаним обрасцима пондера више чворова.

У стварности, текстуре и обриси не би били представљени појединачним чворовима, већ повезаним обрасцима пондера више чворова.

Хронологија

уреди- Године 1958, вишеслојну мрежу перцептрона, која се састоји од улазног слоја, скривеног слоја са рандомизованим пондерима који нису учили, и излазног слоја са везама за учење, већ је представио Френк Розенблат у својој књизи Перцептрон.[10][11][12] Ова машина за екстремно учење[13][12] још није била мрежа за дубоко учење.

- Године 1965, Алексеј Григоревич Ивахњенко и Валентин Лапа, објавили су прву мрежу са дубоким учењем, која још није користила стохастички градијентни спуштања, у то време названу Групни метод руковања подацима.[14][15][12]

- Године 1967, мрежа са дубоким учењем, користећи стохастички градијентни спуста по први пут била је у стању да класификује нелинеарно одвојиве класе шаблона, као што је известио Шуничи Амари.[16] Амаријев ученик Сајто је спровео компјутерске експерименте, користећи петослојну мрежу ширења унапред са два слоја учења.

- Године 1970, је фински истраживач Сепо Линајнма[4][17][12] по први пут објавио модерну методу пропагације уназад, ефикасну примену надгледаног учења заснованог на ланчаним правилима.[18][19] Сам термин (тј. „грешке пропагирања уназад“) је користио сам Розенблат,[11] али он није знао како да га имплементира[12] иако је континуирани прекурзор пропагације уназад већ коришћен у контексту теорије управљања у раду Хенрија Џ. Келија 1960. године.[5][12] Познат је и као реверзни начин аутоматске диференцијације.

- Године 1982, пропагација уназад је примењена на начин који је постао стандард, по први пут од стране Пола Вербоса.[7][12]

- Године 1985, експерименталну анализу технике спровели су Дејвид Е. Румелхарт ет ал.[8] У наредним деценијама направљена су многа побољшања у приступу.[12]

- Године 1987, користећи стохастички градијентни спуст унутар (широке 12-слојне нелинеарне) мреже унапред, Метју Бренд ју је обучио да репродукује логичке функције нетривијалне дубине кола, користећи мале серије насумичних улазно/излазних узорака. Он је, међутим, закључио да је на хардверу (суб-мегафлоп рачунарима) који је био доступан у то време то било непрактично, и предложио је коришћење фиксних насумичних раних слојева као улазног хеша за један слој који се може мењати.[20]

- Током 1990-их, Владимир Вапник и његове колеге развили су (много једноставнију) алтернативу коришћењу неуронских мрежа, иако још увек сродну[21] машини потпорних вектора. Поред извођења линеарне класификације, они су били у стању да ефикасно изврше нелинеарну класификацију користећи оно што се назива трик језгра, користећи високодимензионе просторе карактеристика.

- Године 2003, интересовање за мреже за ширење уназад се вратило због успеха дубоког учења које је Џошуа Бенгио са коауторима применио на моделовање језика.[22]

- Године 2017, уведене су модерне трансформаторске архитектуре.[23]

Референце

уреди- ^ Феррие, C.; Каисер, С. (2019). Неурал Нетwоркс фор Бабиес. Соурцебоокс. ИСБН 1492671207.

- ^ а б Зелл, Андреас (1994). Симулатион Неуроналер Нетзе [Симулатион оф Неурал Нетwоркс] (на језику: Герман) (1ст изд.). Аддисон-Wеслеy. стр. 73. ИСБН 3-89319-554-8.

- ^ Сцхмидхубер, Јüрген (2015-01-01). „Дееп леарнинг ин неурал нетwоркс: Ан овервиеw”. Неурал Нетwоркс (на језику: енглески). 61: 85–117. ИССН 0893-6080. ПМИД 25462637. С2ЦИД 11715509. арXив:1404.7828 . дои:10.1016/ј.неунет.2014.09.003.

- ^ а б Линнаинмаа, Сеппо (1970). Тхе репресентатион оф тхе цумулативе роундинг еррор оф ан алгоритхм ас а Таyлор еxпансион оф тхе лоцал роундинг еррорс (Мастерс) (на језику: фински). Университy оф Хелсинки. стр. 6–7.

- ^ а б Келлеy, Хенрy Ј. (1960). „Градиент тхеорy оф оптимал флигхт патхс”. АРС Јоурнал. 30 (10): 947–954. дои:10.2514/8.5282.

- ^ Росенблатт, Франк. x. Принциплес оф Неуродyнамицс: Перцептронс анд тхе Тхеорy оф Браин Мецханисмс. Спартан Боокс, Wасхингтон DC, 1961

- ^ а б Wербос, Паул (1982). „Апплицатионс оф адванцес ин нонлинеар сенситивитy аналyсис” (ПДФ). Сyстем моделинг анд оптимизатион. Спрингер. стр. 762–770. Архивирано (ПДФ) из оригинала 14. 4. 2016. г. Приступљено 2. 7. 2017.

- ^ а б Румелхарт, Давид Е., Геоффреy Е. Хинтон, анд Р. Ј. Wиллиамс. "Леарнинг Интернал Репресентатионс бy Еррор Пропагатион Архивирано на сајту Wayback Machine (13. октобар 2022)". Давид Е. Румелхарт, Јамес L. МцЦлелланд, анд тхе ПДП ресеарцх гроуп. (едиторс), Параллел дистрибутед процессинг: Еxплоратионс ин тхе мицроструцтуре оф цогнитион, Волуме 1: Фоундатион. МИТ Пресс, 1986.

- ^ Хастие, Тревор. Тибсхирани, Роберт. Фриедман, Јероме. Тхе Елементс оф Статистицал Леарнинг: Дата Мининг, Инференце, анд Предицтион. Спрингер, Неw Yорк, НY, 2009.

- ^ Росенблатт, Франк (1958). „Тхе Перцептрон: А Пробабилистиц Модел Фор Информатион Стораге Анд Организатион ин тхе Браин”. Псyцхологицал Ревиеw. 65 (6): 386–408. ЦитеСеерX 10.1.1.588.3775 . ПМИД 13602029. С2ЦИД 12781225. дои:10.1037/х0042519.

- ^ а б Росенблатт, Франк (1962). Принциплес оф Неуродyнамицс. Спартан, Неw Yорк.

- ^ а б в г д ђ е ж Сцхмидхубер, Јуерген (2022). „Аннотатед Хисторy оф Модерн АИ анд Дееп Леарнинг”. арXив:2212.11279 [цс.НЕ].

- ^ Хуанг, Гуанг-Бин; Зху, Qин-Yу; Сиеw, Цхее-Кхеонг (2006). „Еxтреме леарнинг мацхине: тхеорy анд апплицатионс”. Неуроцомпутинг. 70 (1): 489–501. ЦитеСеерX 10.1.1.217.3692 . С2ЦИД 116858. дои:10.1016/ј.неуцом.2005.12.126.

- ^ Ивакхненко, А. Г. (1973). Цyбернетиц Предицтинг Девицес. ЦЦМ Информатион Цорпоратион.

- ^ Ивакхненко, А. Г.; Григорʹевицх Лапа, Валентин (1967). Цyбернетицс анд форецастинг тецхниqуес. Америцан Елсевиер Пуб. Цо.

- ^ Амари, Схун'ицхи (1967). „А тхеорy оф адаптиве паттерн цлассифиер”. ИЕЕЕ Трансацтионс. ЕЦ (16): 279-307.

- ^ Линнаинмаа, Сеппо (1976). „Таyлор еxпансион оф тхе аццумулатед роундинг еррор”. БИТ Нумерицал Матхематицс. 16 (2): 146–160. С2ЦИД 122357351. дои:10.1007/бф01931367.

- ^ Родрíгуез, Омар Хернáндез; Лóпез Фернáндез, Јорге M. (2010). „А Семиотиц Рефлецтион он тхе Дидацтицс оф тхе Цхаин Руле”. Тхе Матхематицс Ентхусиаст. 7 (2): 321–332. С2ЦИД 29739148. дои:10.54870/1551-3440.1191 . Приступљено 2019-08-04.

- ^ Леибниз, Готтфриед Wилхелм Фреихерр вон (1920). Тхе Еарлy Матхематицал Манусцриптс оф Леибниз: Транслатед фром тхе Латин Теxтс Публисхед бy Царл Иммануел Герхардт wитх Цритицал анд Хисторицал Нотес (Леибниз публисхед тхе цхаин руле ин а 1676 мемоир) (на језику: енглески). Опен цоурт публисхинг Цомпанy. ИСБН 9780598818461.

- ^ Маттхеw Бранд (1988) Мацхине анд Браин Леарнинг. Университy оф Цхицаго Туториал Студиес Бацхелор'с Тхесис, 1988. Репортед ат тхе Суммер Лингуистицс Институте, Станфорд Университy, 1987

- ^ Р. Цоллоберт анд С. Бенгио (2004). Линкс бетwеен Перцептронс, МЛПс анд СВМс. Проц. Инт'л Цонф. он Мацхине Леарнинг (ИЦМЛ).

- ^ Бенгио, Yосхуа; Дуцхарме, Рéјеан; Винцент, Пасцал; Јанвин, Цхристиан (март 2003). „А неурал пробабилистиц лангуаге модел”. Тхе Јоурнал оф Мацхине Леарнинг Ресеарцх. 3: 1137—1155.

- ^ Гева, Мор; Сцхустер, Роеи; Берант, Јонатхан; Левy, Омер (2021). „Трансформер Феед-Форwард Лаyерс Аре Кеy-Валуе Мемориес”. Процеедингс оф тхе 2021 Цонференце он Емпирицал Метходс ин Натурал Лангуаге Процессинг. стр. 5484—5495. С2ЦИД 229923720. дои:10.18653/в1/2021.емнлп-маин.446.